Initialement publié dans le blogue de Direction informatique, le 2 décembre 2013.

Par les temps qui courent, on entend souvent dire que des pratiques transparentes et équitables seraient essentielles afin d’accroître la concurrence entre les soumissionnaires et obtenir un meilleur rapport qualité-prix pour réduire les dépenses publiques.

Dans ce contexte, la publication de données relatives au processus d’octroi de contrats publics contribuerait à la transparence de l’appareil gouvernemental et faciliterait la vigilance des citoyens et des fonctionnaires. Encore faut-il que ces données soient structurées, fiables et cohérentes.

Le cas du SEAO

Les contrats publics du gouvernement du Québec représentaient, en 2011, un marché de plus de 5 milliards de dollars. En juin dernier, le gouvernement du Québec, par le biais du Conseil du Trésor, libérait les données du Système électronique d’appels d’offres (SEAO). Cette plateforme réunit les appels d’offres du gouvernement du Québec, des municipalités et de divers organismes et agences.

Le 16 novembre dernier, lors d’un hackathon organisé à la Maison Notman, à Montréal, des volontaires se sont penchés sur les données ouvertes du SEAO. Une équipe technique a procédé à l’analyse et au nettoyage de l’ensemble de données. Constat : de nombreux champs sont vides, il n’y a pas d’identifiant unique pour les fournisseurs, ni de formats de métadonnées standards et, surtout, on y trouve un grand nombre de doublons, notamment pour les noms d’entreprise. Ainsi, après « nettoyage », le nombre de fournisseurs est passé de 54 692 à 37 579.

Aussi, le modèle de données fourni est bien insuffisant pour contextualiser l’information et les documents enfermés dans des fichiers PDF ce qui interdit une analyse approfondie de leur contenu.

Intégrité des données et qualité de l’information

Une autre équipe a tenté d’évaluer le système du SEAO en regard des directives sur l’ouverture des données des marchés publics qui ont été publiées par la Sunlight Foundation. Cette association internationale fait la promotion de normes et standards pour la transparence des gouvernements.

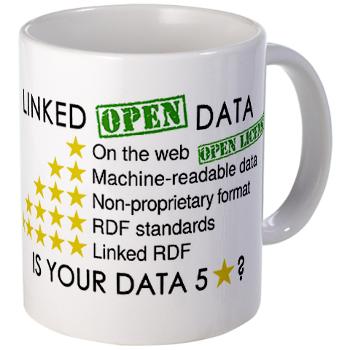

Parmi les lacunes identifiées dans le système, voici des éléments qui sont essentiels à la qualité de l’information, mais malheureusement absents des données publiées :

- Un identifiant unique utilisé de bout en bout du processus de marchés publics, de l’avis d’appel offres jusqu’au rapport des dépenses. Cet identifiant devrait permettre les relations parent-enfant entre les entités à identifier.

- L’adoption de normes existantes pour la diffusion des données et pour assurer l’interopérabilité de celles-ci entre les unités administratives.

- Le texte intégral des contrats.

- L’état des contrats (date d’achèvement prévue, date d’achèvement réelle, dépassements de coût, rendement du contractant).

- Les données concernant la sous-traitance.

Fonctionnaires et élus mieux équipés et plus vigilants

Ces éléments permettraient de concevoir un tableau de suivi des contrats, depuis la rédaction de l’appel d’offres jusqu’à la livraison des produits/services. Ce serait là, plus qu’une preuve de transparence présentée aux citoyens, un véritable outil de surveillance pour les élus et les fonctionnaires dont la visibilité sur les dossiers et les processus n’est, hélas, souvent guère meilleure que celle des citoyens.

Ce n’est cependant réalisable que si l’on améliore la qualité des données à la source, en imposant des règles concernant la divulgation ainsi que des formats de saisie.

Que pouvons-nous attendre du développement de méga systèmes d’information ou même, de « villes intelligentes », si les administrations publiques n’appliquent pas les méthodes et les normes requises pour assurer la qualité des données ?